ساخت یک فایل robots.txt روشی است که با آن می توانید به موتور های جست و جو اعلام کنید که کدام یک از قسمت های وب سایتتان برای موتور جستجو گوگل قابل دسترس است. برای جذب بازدید کننده های بیشتر به وب سایتتان لازم است تنظیماتی را در جهت معرفی وب سایت به موتور های جست و جو انجام دهید. ایجاد یک فایل robots.txt به شما این امکان را می دهد که با قرار دادن آن ورود موتور های جستجو به سایت را کنترل کنید.

آموزش ایجاد یک فایل robots.txt

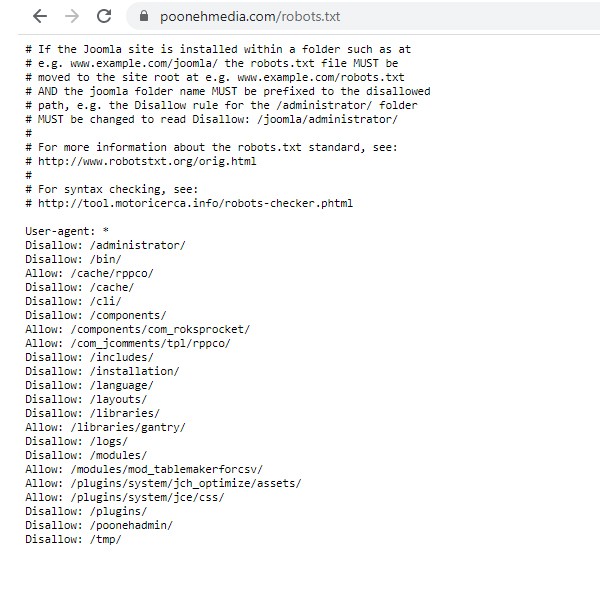

قبل از ایجاد این فایل بررسی کنید که از قبل چنین فایلی در سرور شما ایجاد نشده باشد. برای اطمینان از این مورد کافیست آدرس سایت خود را وارد و در انتهای آن /robots.txt را تایپ و کلید اینتر را بزنید. یعنی به صورت /poonehmedia.com /robots.txt باشد. اگر پس از باز کردن صفحه با ارور 404 مواجه شدید یعنی چنین فایلی از قبل ایجاد نشده است. اما در صورتی که پس از وارد کردن این عبارت در انتهای نام دامنه وب سایت، با کد های مربوط به فایل robots.txt روبرو شدید یعنی این فایل برای وب سایت از قبل موجود می باشد. در این حالت می بایست به کنترل پنل هاست خود مراجعه کنید و در قسمت روت اصلی وب سایت این فایل را پیدا کنید. بعد از پیدا کردن این فایل توسط یک ویرایشگر متنی، فایل robots.txt را باز کنید و آن را ویرایش کنید. همچنین می توانید آن را روی سیستم خود ذخیره وپس از ویرایش مجددا روی هاست آپلود کنید.

اگر قادر به یافتن این فایل در هاست خود نشدید یک فایل متنی از طریق Notepad بسازید و آن را با نام robots ذخیره کنید. دقت کنید که حتما از حروف کوچک برای نام گذاری استفاده شود. دستورات مد نظر خود را در این فایل تایپ کنید و در نهایت فایل ایجاد شده را از طریق هاست و در روت اصلی آپلود کنید.

دستورات فایل Robot.txt

فایل robots.txt به فایل متنی شامل ساختار ساده گفته می شود. عملکرد این فایل با استفاده از دستورات پیش فرضی که در آن قرار گرفته شده است تعیین می شود. از مهم ترین دستورات موجود در این فایل می توان به دستوراتی مانندAllow ، User-agent، Disallow ، Crawl، delay و Sitemap اشاره کرد که پونه مدیا در ادامه به بررسی این موارد خواهد پرداخت.

ساده ترین فایل Robot.txt شامل دو دستور است :

- User-Agent : تعیین قانون برای انتخاب ربات .

- Disallow : آدرسی که میخواهید مسدود شود.

همین دو دستور را در یک فایل متنی قرار دهید و نام آن را Robots.txt بگذارید و فایل را در ریشه ی دامنه ی خود آپلود کنید. عملیات مورد نظر انجام گرفت. در این فایل شما می توانید هر چند خط که می خواهید قرار دهید برای مثال :

User-Agent:*

Disallow:/folder1/

User-Agent:googlebot

Disallow:/folder2/

bots و User – agents

User-Agent یک ربات مخصوص موتورهای جستجو می باشد. وقتی که می نویسیم *:User-Agent یعنی هر موتور جستجویی که سراغ سایت می آید این قانون برایش اعمال گردد. گوگل برای جستجوهایش از ربات های مختلفی استفاده می کند ولی برای جستجوی وب از googlebot استفاده می نماید.

خط disallow صفحاتی را که شما می خواهید مسدود شوند لیست می کند.

برای مسدود کردن یک پوشه و هر چیزی که داخل آن است

Disallow:/junk-directory/

برای مسدود کردن کامل یک سایت برای ربات ها

Disallow:/

برای مسدود کردن یک صفحه برای ربات ها

Disallow:/privat-file.html

برای مسدود کردن یک عکس برای موتور جستجوی گوگل

user-agent:Googlebot-image

Disallow:/images/dogs.jpg

برای خارج کردن همه ی عکس های وب سایت از قسمت عکس گوگل

user-agent:googlebot-image

Disallow:/

برای خارج کردن فایل هایی که پسورد خاصی دارند از نتایج جستجوی گوگل

user-agent:Googlebot

Disallow:/*.gif$

دقت داشته باشید که کوچکی و بزرگی حروف از اهمیت بالایی برخوردار است

محدودیت های الگویی در فایل Robot.txt

محدودیت های الگویی برای برخی از سایت ها ز جمله گوگل جواب می دهد اما الزاما برای همه سایت ها جواب نمی دهد. برای مسدود کردن همه ی شاخه هایی که با یک کلمه ی خاص مثلا private شروع می شوند از علامت (*) ستاره استفاده می کنیم.

user-agent:googlebot

Disallow:/private*

برای مشخص کردن و کنترل آخر یک آدرس که مثلا به xls ختم می شود

user-agent:googlebot

Disallow:/*.xls$

شما برای حالت الگویی می توانید از دستور allow هم استفاده کنید مثلا اگر بخواهید URLهای شما را کنترل کند و دوباره هم ایندکس نشود. یا آدرس هایی که به ؟ ختم میشود را فقط کنترل کند

user-agent:*

allow:/*$

Disallow:/*?

خط اول یعنی همه ی آدرس هایی که به ؟ ختم می شوند را ایندکس کن

خط دوم یعنی همه ی آدرس هایی که به ؟ ختم می شوند را ایندکس نکن

تاثیر فایل robots.txt در سئو وب سایت

همان طور که استفاده از دستورات robots.txt در اکثر مواقع پیشنهاد می شود وممکن است در کمپین سئو سایت شما تاثیر بسزایی داشته باشد زیاده روی و یا اشتباه نوشتن کد های این فایل می تواند موجب ایجاد نتیجه عکس برای وب سایت شما شود. پس نکات زیر را به دقت بخوانید و با در نظر گرفتنشان یک فایل متناسب با اصول سئو ایجاد کنید.

1- فایل robots.txt سایت خود را بررسی کنید و مطمئن شوید که بخشی از وب سایت از طریق آن بلاک نشده باشد.

2- در این بررسی ها مطمئن شوید که فایلها و پوشههای مهم CSS و JS مسدود نشده اند. با توجه به این که ربات های گوگل از دید یک کاربر به وب سایت شما نگاه می کنند پس مسدود شدن این موارد می تواند باعث لود شدن نادرست صفحات وب سایت شود و این مسئله خود می تواند در باعث ایجاد خطا و ایندکس نشدن سایت شود.

3- سعی کنید از دستورات پیچیده ای استفاده نکنید. اگر دستور خاصی مد نظرتان است آن را با کمک کد User-agent: * روی تمام ربات ها اعمال کنید.

اگر مایلید بعضی از صفحات وب سایت در گوگل اینکس نشود از متا تگ های هدر استفاده کنید. البته این کار زمانی کارایی دارد که تعداد صفحات کم باشد و یا انجام این فرآیند دشوار نباشد.

نتیجه گیری

ساخت یک فایل robots.txt زمان زیادی از شما نخواهد گرفت و نیازی به آزمون و خطای آن به صورت مستمر نیست. اگر به دنبال بررسی های بیشتر این ابزار هستید استفاده از ابزار آنلاین Google Search Console می تواند به شما در مدیریت این فایل کمک کند. در Google Search Console فایل robots.txt را مدیریت، ویرایش، بروز رسانی و اشکال زدایی کنید. پیشنهاد می شود از بروز رسانی مستمر این فایل خود داری کنید. بروزرسانیهای مستمر این فایل اگرچه در روند فعالیت سایت شما به ظاهر تأثیر زیادی نخواهد گذاشت، اما میتواند منجر به پیچیده شدن فرآیند دسترسی ربات های گوگل به وب سایت شما شود. بهترین زمان برای ساخت یک فایل robots.txt درست بعد از راه اندازی وب سایت می باشد.